日期:2025-08-10

版本:0.11.3

日期:2025-07-08

版本:0.9.5

日期:2025-06-16

版本:0.9.0

Ollama最新版是一款非常实用的大型语言模型本地化软件,软件界面简洁,操作简单易用,采用的是轻量级框架,不会占用太多的资源,提供了多种命令,方便用户进行模型管理和推理,如查看帮助信息、查看可用模型、拉取模型、删除模型、检查模型状态等,感兴趣的小伙伴快来下载体验吧!

1、硬件加速和资源优化

GPU加速:在支持CUDA或Metal的设备上,通过GPU可以显著提高推理速度。

资源管理:通过环境变量优化硬件资源的使用(如Olama _ keep _ alive控制模型的内存驻留时间,Olama _ max _ VRAM限制内存占用)。

2、API和多语言支持

RESTAPI:兼容OpenAI接口标准,开发者可以通过/api/generate和/api/chat接口生成文本或实现对话功能。

客户端集成:支持Python、Java、C#等语言调用,方便与其他应用(如Web界面、桌面客户端)集成。

3、本地化部署

Ollama支持在macOS、Linux和Windows(预览版)系统上运行,不依赖云服务。用户可以通过Docker容器或直接安装包进行部署,以确保数据隐私和低延迟响应。

4、模型管理便捷

模型仓库:提供预建的模型库(如Llama3、Phi3、Gemma2等),用户可以通过ollamapull快速下载。

自定义模型:支持通过Modelfile定义模型参数(如温度值、系统提示等),并基于现有模型创建个性化版本。比如可让模型以特定角色(如马里奥)回答问题。

多模型并行:支持同时加载多个模型,通过调整num_ctx参数控制上下文长度。

ollama本地部署需要什么配置?

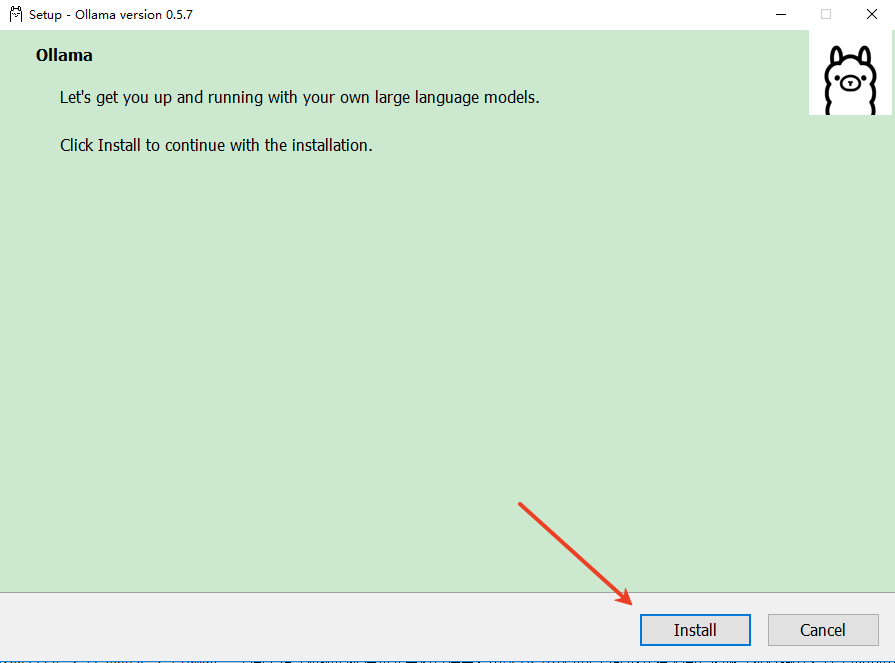

1、解压后,运行ollamasetup.exe,弹出安全警告,点击“运行”;

2、开始安装,点击“install”,片刻后就能安装完成。

日期:2025-08-10

版本:0.11.3

日期:2025-07-08

版本:0.9.5

日期:2025-06-16

版本:0.9.0

ds大模型安装助手官网版

下载

八宝模型库插件旧版本

下载

Mockup Creator(程序模型设计工具) 3.4

下载

FinalMesh(三维模型查看器)v3.2.1.525

下载

Wallhavenv4.4.7

下载

效能桌面便笺官方版

下载

LeawoFreeScreenRecorderv1.0.0.1

下载

雨滴桌面秀v4.5.21

下载65.37MB

2025-10-10

15.30MB

2025-10-10

67.73MB

2025-10-10

2.42MB

2025-10-10

109.96MB

2025-10-10

14.86MB

2025-10-10

84.55MB / 2025-09-30

248.80MB / 2025-07-09

2.79MB / 2025-08-22

63.90MB / 2025-07-08

1.90MB / 2025-09-07

210.99MB / 2025-06-09

374.16MB / 2025-01-24

京ICP备14006952号-1 京B2-20201630 京网文(2019)3652-335号 沪公网安备 31011202006753号违法和不良信息举报/未成年人举报:legal@3dmgame.com

CopyRight©2003-2018 违法和不良信息举报(021-54473036) All Right Reserved

玩家点评 (0人参与,0条评论)

热门评论

全部评论